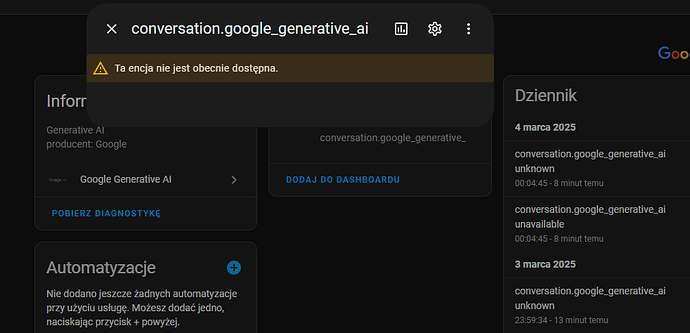

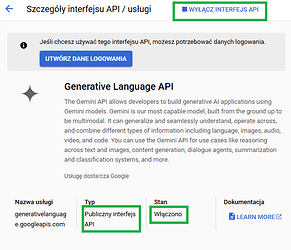

Co jest nie tak ? dodałem integracje google AI, wszystko przeszło można konfigurować. ale encja jest nie dostępna:

Może będzie dostępna jak coś zostanie do niej przesłane?

Za co odpowiada ta encja?

Mam Skrypt:

alias: Co widzi kamera

sequence:

- target:

entity_id: camera.parking

data:

filename: /media/kamera/parking_foto.jpg

action: camera.snapshot

- delay:

hours: 0

minutes: 0

seconds: 2

milliseconds: 0

- data:

image_filename: /media/kamera/parking_foto.jpg

prompt: |

Co widzisz?

Nie podawaj daty i czasu z kamery

response_variable: cowidzisz

action: google_generative_ai_conversation.generate_content

- delay:

hours: 0

minutes: 0

seconds: 1

milliseconds: 0

- data:

message: |

{{ cowidzisz.text }}

action: notify.mobile_app_xx

- data:

message: TTS

data:

media_stream: alarm_stream_max

tts_text: |

{{ cowidzisz.text }}

action: notify.mobile_app_xx

- target:

entity_id: input_text.co_widzisz

data:

value: "{{ cowidzisz.text }}"

action: input_text.set_value

mode: single

description: ""

Po zapytaniu asystenta w HA “Co widzi kamera” , asystent (AI) mówi “uruchamiam skrypt” i po paru sekundach otrzymuje powiadomienia na temat opisu widoku z kamery.

Działa OK.

Brakowało mi bardziej szczegółowych odpowiedzi - na dynamiczne pytania.

Stworzyłem następny skrypt:

alias: Co widzi kamera z danymi

sequence:

- target:

entity_id: camera.parking

data:

filename: /media/kamera/parking_foto.jpg

action: camera.snapshot

- delay:

hours: 0

minutes: 0

seconds: 3

milliseconds: 0

- data:

image_filename: /media/kamera/parking_foto.jpg

prompt: |

Odpowiadaj po polsku. Zwykły tekst bez znaków specjalnych

{{ states('input_text.pytanie_do_kamery') }}

response_variable: cowidzisz

action: google_generative_ai_conversation.generate_content

- delay:

hours: 0

minutes: 0

seconds: 1

milliseconds: 0

- data:

message: "{{ cowidzisz.text }}"

action: notify.mobile_app_xxx

- data:

message: TTS

data:

media_stream: alarm_stream_max

tts_text: "{{ cowidzisz.text }}"

action: notify.mobile_app_xxx

- data:

entity_id: input_text.co_widzisz

value: "{{ cowidzisz.text }}"

action: input_text.set_value

mode: single

description: Automatyzacja zadania pytania o to, co widzi kamera.

/

input_text:

co_widzisz:

name: Co widzisz

pytanie_do_kamery:

name: Pytanie do kamery

initial: "Co widzi kamera?" # domyślne pytanie

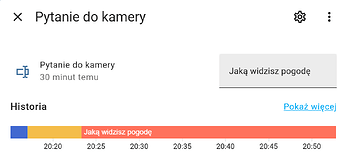

Po wprowadzeniu teksu (pytania)

I uruchomieniu skryptu otrzymuje odpowiedz na zadane pytanie

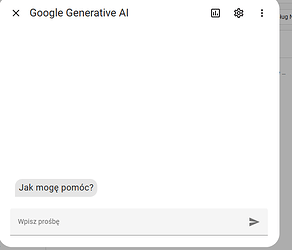

Chciałby zapytując asystenta w HA np. “co widzi kamera” a następnie by on zapytała mnie o dotykowe informacje.

Po udzieleniu odpowiedzi np. “ile aut jest na podjeździe” , “czy jest auto o numerze rejestracyjnym XXXXX” , “Czy brama otwarta”

Odpowiedz została by zapisana do input_texta następnie uruchomiony skrypt który to by udzielił konkretnej odpowiedzi.

![]()

Asystent nie jest w stanie dokonać zmiany wartości w enacjach.

Docelowo chciałbym otrzymywać powiadomienia np.

Listonosz

Przesyłka

Podjechał samochód Franka

Zamrożone szyby w samochodzie itp.

![]()

Wracając do tematu:

Jak można inaczej to skonfigurować ?