motioneye #notifications #mail #motion #detection tapo #camera telegram

Kto pyta nie błądzi, wiele razy mi pomogliście za co bardzo dziękuję.

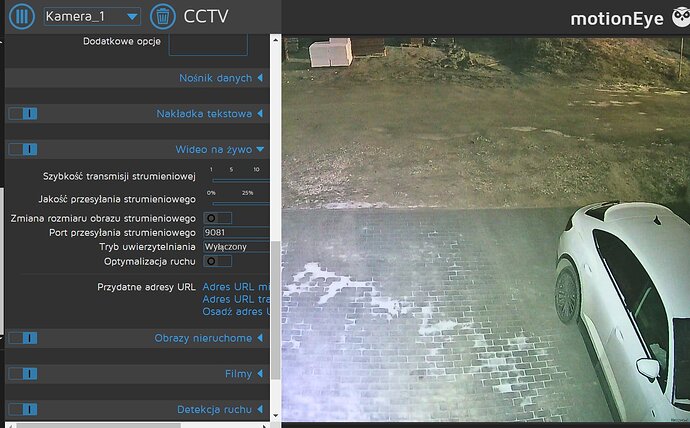

Udało mi się w końcu dodać kamery Tapo C210 do dodatku Motioneye i uzyskać z nich obraz, nawet udało się w tym dodatku podpiąć dysk sieciowy, który utworzył sobie sam foldery dla danej kamery

Utworzyłem też w Telegramie bota dla powiadomień z Motioneye, bo opcja maila niestety z jakiegoś powodu wywala błąd ![]() (kiedyś jeszcze podejmę temat na razie ten rodzaj powiadomienia odpuszczam)

(kiedyś jeszcze podejmę temat na razie ten rodzaj powiadomienia odpuszczam)

Teraz chciałbym sprawdzić, czy te wszystkie ustawienia działają i tak:

Czy detekcja ruchu w Motioneye ustawiona na ON musi być jednocześnie ustawiona też na ON w apce kamerki Tapo, żeby dodatek z HA zaczął zapisywać zdarzenia na dysku sieciowym?

W kamerce mam wsadzone karty pamięci, ale w aplikacji Tapo wyłączyłem taki sposób zapisywania, a może je lepiej wyjąć?

Może ta informacja też będzie ważna, bo w ustawieniach Motioneye kamery mam wyłączona opcję video streaming (ma być włączona?)

Myślę, że jak zadziała zapis detekcji ruchu to z powiadomieniem na Telegram już chyba nie powinno być problemu, bo w ustawieniach tego typu powiadomień jest tylko opcja wpisania tokenu bota i jego ID, więc raczej błędu tutaj nie zrobiłem, bo nawet test wykazał sukces ![]()

Ktoś ma jakieś sugestie, chętnie przeczytam wszystkie.

BTW zauważyłem, że jak wstawię streaming wysokiej jakości do Motioneye to dodatek bardzo dużo zużywa procesora, też tak macie?