Nie do końca wiem, gdzie rzucić temat, czy pod NR, czy pod HA ![]() Raczej to luźna forma dyskusji.

Raczej to luźna forma dyskusji.

Obecnie coraz więcej się mówi o różnych AI, czy to ChatGPT, czy inne tego typu. I prawdę powiedziawszy, to bardzo pędzi i zaskakuje. Zastanawiam się, jak to może wpłynąć na sam temat tego wszystkiego, co mamy w domu.

Już gdzieś mi się przewinął temat, że ktoś podpinał chyba właśnie ChatGPT pod NR i tam wysyłał dane z domu. Nie wiem do końca na ile to rozwiązanie jest bezpieczne. Ktoś już wgryzał się w ten temat?

Wybiegając w przyszłość, to co jeszcze może zrobić AI w domu, a co jeszcze, w teorii, nie robi? Patrząc na to, że na teraz działa na danych historycznych, statystyce i próbuje w pewien sposób przewidzieć, zaplanować działania, to również pewne typy automatyzacji by pod to pasowały. Tak mi się wydaje. Lepsze zarządzanie ogrzewaniem na podstawie znanych danych historycznych z pomiarów temperatur, wilgotności i ciśnienia? Tworzenie lokalnego modelu warunków klimatycznych?

Temat skomplikowany. Z moich przemyśleń: rozwiązania AI typu ChatGPT to zabawka. Problem w tym, że naprawdę mało kto wie jak to naprawdę działa. Ot, generuje fajne rzeczy ale żeby w obecnej formie go wykorzystać w systemach smart? Nie. Powierzanie funkcji sterowania narzędziu, którego sposób dziania jest nieprzewidywalny to spore ryzyko.

Wysyłanie danych do AI to jak wysyłanie do chmury - nigdy nie wiesz do kogo trafiają i co ktoś z tym zrobi. Jest to bezpieczne, o ile nagle się nie okaże że dane gdzieś wyciekły i jakaś smart-żarówka wysłała do Chin 4GB danych z naszej sieci ![]() Można to traktować jako żart albo paranoję, ale zarządzając taką chmurą albo AI miałbym piekielnie silną pokusę aby te dane wykorzystać - bo to aż się prosi.

Można to traktować jako żart albo paranoję, ale zarządzając taką chmurą albo AI miałbym piekielnie silną pokusę aby te dane wykorzystać - bo to aż się prosi.

Co oczywiście nie zmienia faktu, że od AI w systemach smart się nie ucieknie, bo to kolejny krok w kierunku automatyzacji. Bardzo by mnie ucieszyło, aby mój smart-piec powiedział “hejka, planowane jest jutro ochłodzenie, więc strefowo podkręcę nieco grzanie, poza tym jutro masz randkę, a ona lubi gorące kąpiele”. Czyli wszystko jest smart, planowane przewidywane, tylko - skąd on to wie? ![]()

Trzeba zacząć od początku,

czyli machine learning samego czujnika

jak ktoś to ogarnie to rozbije bank

w zasadzie nie jest tak trudne jak się wydaje.

Frigate działa dokładnie tak samo.

Tensorflow świetnie wytłumaczone:

Jak już to będzie ogarnięte, czyli dostarczymy danych z czujników i “wykonywaczy”

Ponowny proces uczenia, dajemy dostęp do “wykonywaczy” i mamy AI w domu.

Rok, może dwa, ktoś do tego usiądzie i będzie pozamiatane

To tak pokrótce…

Gołym okiem widać że to rozdmuchiwana BAŃKA, pewnie wpompowano miliardy $ i trzeba teraz znaleźć jeleni którzy wyłożą kasę by nie było wielkiego BUM.

Na pewno nieprosty. Raczej w mojej opinii jest to przyszłość, chyba że będzie zastopowana odpowiednimi przepisami. Patrząc jak to się rozwija, warto już patrzeć w tą stronę, by nie przegapić odpowiedniego momentu.

Co do wysyłania danych, to tutaj jest fakt. Nie panujemy nad tym, co już zostało potwierdzone. Co prawda ChatGPT akurat nie jest powiązany z Chinami, ale jednak nasze dane lecą do trenowania i mogą gdzieś wypłynąć, co już się zdarzyło. Przykład? Jakiś czas temu wypłynęły dane z Samsunga, które były z wewnętrznej prezentacji. Prawdopodobnie ktoś wewnątrz używał ChatGPT do tworzenia materiałów na potrzeby wewnętrzne. Było też coś z Amazonem.

Tu się nie do końca zgodzę. Grubą kasę na finansowanie tego wydał Microsoft. 10 miliardów? I do tego chyba dołożył miejsce na swoich serwerach. Ale za to ma chyba 70% od sprzedaży przez 10 lat, a potem staje się właścicielem połowy? Jakoś tak. Pewnie w tym czasie ten mechanizm zostanie zaszyty w system.

Inna sprawa, że te rozwiązania będą napędzać wszystkich asystentów głosowych. I nie tylko. Im większa wiedze będzie posiadał sam mechanizm, tym bardziej racjonalnie będzie przedstawiał wyniki. Tutaj wszystko zależy od samego mechanizmu trenowania sieci neuronowej. Co z tego wyjdzie, zobaczymy.

Z takich historii z tego tematu, to dało się wyszkolić GPT4 do pisania odwołań od mandatów :), ale też ten mechanizm zdał egzamin studencki (nie pamiętam jaki stopień naukowy) w stanach z medycyny. Do tego na podstawie danych medycznych potrafił wykryć chorobę, która występuje 1 na 100 000, czyli nie tak popularna. Jak dla mnie to właśnie do szybkiego wyciągania wniosków na podstawie dostępnych danych, to będzie idealne narzędzie. Bo to matematyka, statystyka i pokrewne.

Inna sprawa, ze translatory działające na podstawie sieci neuronowej (DeepL) działają nieźle.

Nie zagłębiając się w wiedze co może ChatGPT, to widzę pierwsze zastosowania, Konsultant (Banku brzmiący jak ten którego znasz) bez znanego akcentu ![]()

Nasze, twoje, moje dane już dawno wypłynęły i już nie masz czego ukrywać, jedyne co możesz jeszcze chronić to twoje dane jak hasła:/loginy: do kont bankowych aby cię nie okradli.

Firmy farmaceutyczne i wszyscy z nimi powiązani nie będą z tego korzystać bo ich biznes plan to

Na czym najwięcej w tym roku zarobimy.

- Rak 50 MLD

- …

3 …

4…

5…

Niestety nie ma żadnego punktu ile osób wyleczymy i jakim chorobom zapobiegniemy.

Zgadzam się korzystałem, ale któraś tam wersje wieszała się totalnie, ale tu stawiam że to problem windowsa.

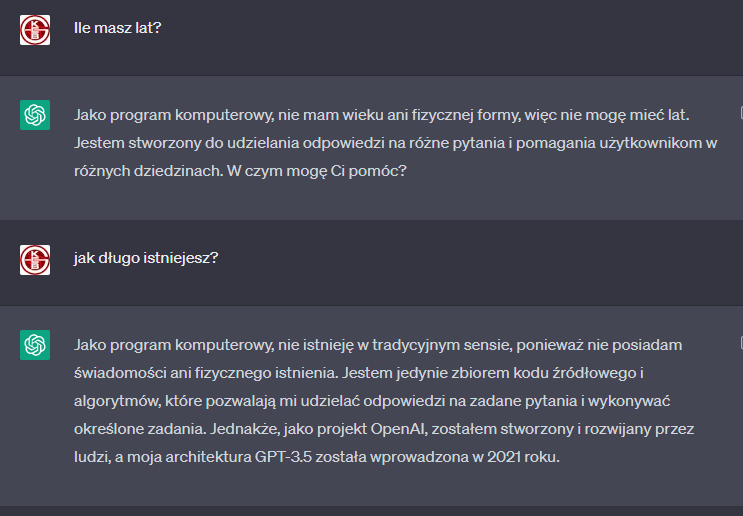

Ciekawe ile ma lat ChatGPT ?

Trochę w temacie właśnie jest transmisja “Year of the Voice - Chapter 2”

trochę z wiadomych względów zahacza o tematy AI

AI sprawdzi się wszędzie, gdzie praca jest “algorytmiczna”. Zamiast “białkowego” konsultanta, który nie zawsze zna wszystkie regulaminy, oferty i promocje - dajemy takiego AI-bota, “karmimy” 15GB regulaminów, produktów, ofert i dokumentów, dodajemy rozpoznawanie mowy oraz TTS, do tego prościutki algorytm typu “znajdź punkt piąty regulaminu oferty sprzed pół roku” - i mamy idealnego konsultanta. Sprzedawca, kierowca, projektant - te zawody będą wymierać, a dokładniej to wszystkie zawody nie-fizyczne.

Podłączenie chatGPT to nie jest problem. Można użyć LangChain, stworzyć narzędzie i się pobawić.

LangChain:

Wygląda to tak (celowo nie zamieszczam całego kodu i kod jest w JS):

class GetEntityStateByEntityId extends Tool {

name = "GetEntityStateByEntityId - Obtain sensor state using entity ID"

description = `

This tool can be utilized to obtain the state of a sensor.

The input required is the sensor's entity ID.

The input must consist of a single word.

This tool should be used exclusively when the entity ID is retrieved from GetEntityByName.

`

/ ...

}

class GetEntityBySensorType extends Tool {

name = "Get Entity ID by Sensor Type"

description = `

This tool can be used to list all devices that match the provided input.

The input should be a single-word text representation of the sensor type.

`

/ ...

}

class GetEntitiesByArea extends Tool {

name = "Get Entity IDs by Area"

description = `

This tool can be used to list all devices located in a specific area.

The input should be a single-word text representation of the area, room, or zone.

`

/ ...

}

Aaa i do HA jest jakis dodatek który tworzy zwektoryzowaną bazę na podstawie danych z bazy HA, chyba w Pinecone, ale tylko mi mignął przed oczami i nie pamiętam dokładnie.

Od tej pory chatGPT wie gdzie szukać i o co ci chodzi gdy mówisz “światło w salonie” albo “temperatura w łazience”. W ten sam sposób podłączasz wykonywanie akcji (np. wysyłanie po MQTT).

Co śmieszne, jeśli dasz mu dokumentacje samego siebie, to w zasadzie sam wszystko napisze i to prawidłowo. Dokumentacji HA nie potrzeba, bo chatGPT (szczególnie GPT 4) świetnie sobie radzi w HA.

ChatGPT potrafi wychwytywać kontekst dotyczący domu, sensorów i urządzeń z rozmowy, i robi to doskonale. Jeśli ktoś jest bogaty (gtp4 i tokeny api) i odważny (wysyłać wszystko do sieci) może podłączyć jakiś system rozpoznawania mowy, i dosłownie strumieniować wszystko co się mówi. Dzięki temu nie musisz używać hotworda (np. bez wołania Alexa!).

Z czym jeszcze sobie świetnie radzi to rozpoznawanie encji, np. “Włącz coś Nicka Cave’a na głośnikach w salonie” i włączy.

Z dodatkowych cudów: listy zakupów, jeśli podłączysz GPS i ogarniasz dane z overpass-turbo, to mówiąc “przypomnij żebym kupił chleb”, i będziesz koło piekarni to przypomni. I naprawdę świetnie sobie radzi, bo nawet listy posortuje wg. działów w supermarkecie.

Co do ML - ogarnianie czujników też nie jest skomplikowane, dajmy na to że masz 4 LD2410 w pokoju, i nie chce Ci się bawić w ręczne ogarnianie, by ktoś przechodząc koło drzwi nie włączał światła. Wtedy bierzesz i zapisujesz dane, dla różnych sytuacji, wrzucasz w tensorflow i uczysz, wymaga trochę wiedzy i cierpliwości ale do zrobienia. U mnie to wygląda tak że mam 2 przyciski w apce, po naciśnięciu odpowiedniego zapisuje dane z sensorów, chodzę i klikam “obecność”/“brak obecności” a potem ćwiczę klasyfikację. GPT jest tutaj bardzo pomocny bo pomaga w ekstrakcji ficzerów i modelowaniu tensorflow.

Podobnej techniki możesz użyć do przewidywania zachowań użytkowników, ale wtedy potrzebne by były dane z roku, lub conajmniej kilku miesięcy, żeby miało to ręce i nogi. No i potrzebna wyrozumiała i cierpliwa żona.

Dodam jeszcze, że odrobinę bardziej zaawansowany model GPT (chociaż w zasadzie dostępność, tzn niższa cena i bardziej rozbudowane narzędzia) i nie będzie potrzeby istnienia home assistanta i innych tego typu wynalazków, wystarczy API urządzenia a EjAj sam sobie wszystko poustawia, łącznie z dashbordami.

GPT4 -Mówi się że mentalnie to ośmiolatek.

OpenAI zajmuje się tym od 6-7 lat.

EDIT: Jak przeczytam swoje wypociny po kilku godzinach, to się za głowę łapie, gramatycznie i słownikowo jakaś mieszanka polsko-niemiecko-angielska mi wychodzi ![]()

Całkiem fajnie napisane. I jak widać, to ma potencjał. Tylko trzeba do tego podejść w odpowiedni sposób. Bo to tylko dodatkowe narzędzie, które ma wspomagać. I tyle.

Te rozwiazania, o których piszesz to są po prostu kody w pythonie, czy jakieś dockery, czy jeszcze coś innego?

tak to są kody w python albo js.

Tutaj jest przykład takiego narzędzia w pythonie do uruchamiania komend w bashu:

A tu cała lista gotowych i zarys koncepcyjny, w ten sam sposób można zbudować sobie tool do wszystkiego, od włączania światła po analizę prawną projektów ustaw:

https://python.langchain.com/en/latest/modules/agents/tools/getting_started.html

W skrócie GPT wie do czego służy funkcja i sam potrafi wydedukować że powinien jej użyć, langchain ogarnia wszystkie niuanse z tym związane. Jest to nawet oficjalnie zaimplementowane przez OpenAI jako “plugins” ale dostępne tylko dla wybranych i ciężko dostać dostęp (ja czekam i czekam i nic)

Generalnie i IMO najlepiej rozumieć to tak:

model językowy to nie chatbot, to narzędzie które operuje językami, opisem, czy to ludzkimi, czy programistycznymi, czy meta językami, potrafi zbudować opis na podstawie czegoś. Taki opis to może być opis algorytmu - działania HA, procesu produkcji mebli kuchennych czy równań matematycznych.

Jeśli model językowy wyposażymy w możliwość działania, czyli np. obsługi robota czy systemu matematycznego (np. wolfram), to on sobie poradzi, ale może to też być opis procedury projektowania nowej metody litografii do tworzenia procesorów (NVidia właśnie, jakoś miesiąc temu, sprowadziła miesiące obliczeń procesu naświetlania krzemu do minut).

Taki model językowy świetnie się sprawdza jako koordynator, czyli agent lub seria agentów, kontrolująca inne modele i zewnętrzne funkcje. Czyli mimo że na pierwszy rzut oka ma się wrażenie że to poprostu rozwinięty chatbot, on jest w stanie kierować całą linią produkcyjną mebli: robotami, kontrolą jakości, maszynami numerycznymi - wszystkim co da się opisać w jakiś sposób. Do tego jest encyklopedią mogącą łączyć fakty tak zawiłe że niedostępne dla ludzkiego mózgu.

I to we dwie strony, bo jest w stanie interpretować feedback i wywnioskować co z tym zrobić. I to nie jest inteligencja w rozumieniu istoty, to wyrafinowana sztuczka która uświadomiła nam w ostatnich miesiącach, że nie potrzeba inteligentnego samoświadomego bytu by zastąpić 90% naszych zadań.

Niestety koszta obliczeń i trenowania są wciąż wysokie, więc sprowadzenie GPT-4 do obsługi domu (czyli zabawki) to duży i nieuzasadniony wydatek. Inaczej to wygląda z chatGPT-3.5-turbo, tylko tutaj jest zbyt dużo błędów.